Grafikus feldolgozó egység - Graphics processing unit

A grafikus feldolgozó egység ( GPU ) egy speciális elektronikus áramkör célja, hogy gyorsan manipulálni és Alter memóriát , hogy gyorsítsák létrehozása képek egy frame buffer szánt kimenet egy megjelenítő eszköz . A GPU -kat beágyazott rendszerekben , mobiltelefonokban , személyi számítógépekben , munkaállomásokon és játékkonzolokon használják .

A modern GPU -k nagyon hatékonyan manipulálják a számítógépes grafikát és a képfeldolgozást . Rendkívül párhuzamos felépítésük hatékonyabbá teszi őket, mint az általános célú központi processzorok (CPU-k) az algoritmusok számára, amelyek nagy adattömböket párhuzamosan dolgoznak fel. A személyi számítógépekben a GPU jelen lehet videokártyán, vagy beágyazva az alaplapra . Bizonyos CPU -kban ezek be vannak ágyazva a CPU szerszámba .

Az 1970 -es években a "GPU" kifejezés eredetileg a grafikus processzor egységet jelentette, és egy olyan programozható feldolgozóegységet írt le, amely a CPU -tól függetlenül működik, és felelős a grafikai manipulációért és a kimenetért. Később, 1994 -ben a Sony a PlayStation konzol Toshiba által tervezett 1994 -es Sony GPU -jára hivatkozva használta ezt a kifejezést (ma grafikus feldolgozó egység ) . A kifejezést 1999 -ben népszerűsítette az Nvidia , aki a GeForce 256 -ot a világ első GPU ". „Egy chipes processzorként mutatták be, integrált átalakítással, világítással, háromszög-beállítással/kivágással és renderelő motorokkal”. A rivális ATI Technologies megalkotta a " vizuális feldolgozó egység " vagy VPU kifejezést a Radeon 9700 megjelenésével 2002 -ben.

Történelem

1970 -es évek

Az Arcade alaplapok az 1970 -es évek óta használnak speciális grafikus áramköröket. A korai videojáték -hardverekben a keretpufferek RAM -ja drága volt, ezért a videóchipek összevonták az adatokat, miközben a kijelzőt a monitoron szkennelték.

Egy speciális hordóváltó áramkört használtak, hogy segítsék a CPU -t animálni a keretbuffer grafikát a 1970 -es évek különböző arcade -játékaiban a Midway -től és a Taitótól , mint például a Gun Fight (1975), a Sea Wolf (1976) és a Space Invaders (1978). A Namco Galaxian árkádrendszer 1979-ben speciális grafikus hardvereket használt, amelyek támogatják az RGB színeket , a többszínű sprite- okat és a csempéptérkép háttereket. A galaxis hardvert széles körben használták az arcade videojátékok aranykorában olyan játékcégek , mint a Namco , Centuri , Gremlin , Irem , Konami , Midway , Nichibutsu , Sega és Taito .

A hazai piacon az Atari 2600 1977 -ben a televíziós interfész adapter nevű videóváltót használta . Az Atari 8 bites számítógépeiben (1979) volt ANTIC , videó processzor, amely értelmezte a "megjelenítési listát" leíró utasításokat-a letapogatási vonalak meghatározott bitképes vagy karakteres módokhoz való hozzárendelését és a memória tárolási helyét (tehát nem volt szükség legyen összefüggő keretpuffer). 6502 gépi kód alprogramot lehet elindítani a szkennelési vonalakon, ha beállít egy bitet a megjelenítési lista utasításában. Az ANTIC támogatta a CPU -tól független sima függőleges és vízszintes görgetést is .

1980 -as évek

A NEC µPD7220 volt az első olyan számítógépes grafikus kijelző processzor megvalósítása, amely egyetlen nagyméretű integrált (LSI) integrált áramköri chipként lehetővé tette az alacsony költségű, nagy teljesítményű videokártyák tervezését, mint például a Number Nine Visual Technology . A nyolcvanas évek közepéig ez lett a legismertebb GPU. Ez volt az első teljesen integrált VLSI (nagyon nagy léptékű integráció) fém-oxid-félvezető ( NMOS ) grafikus kijelző processzor PC-khez, 1024x1024 felbontásig támogatva , és megalapozta a feltörekvő PC-grafikus piacot. Számos grafikus kártyán használták, és klónokhoz is licencelték, mint például az Intel 82720, az Intel első grafikus feldolgozó egysége . A Williams Electronics Robotron 2084 , Joust , Sinistar és Bubbles arcade játékok 1982-ben jelentek meg , és egyedi blitter chipeket tartalmaznak 16 színű bitképeken való működéshez.

1984 -ben a Hitachi kiadta az ARTC HD63484 -et, az első nagyobb CMOS grafikus processzort PC -re . A ARTC volt képes megjeleníteni akár 4K felbontású , amikor fekete-fehér módban, és arra használták, hogy számos PC grafikus kártyák és terminálok a késő 1980-as években. 1985 -ben a Commodore Amiga egyedi grafikus chipet kapott, egy blitter egységgel, amely felgyorsítja a bitképek kezelését , a vonalhúzást és a területkitöltési funkciókat. Tartozik hozzá egy koprocesszor is , saját egyszerű utasításkészlettel, amely képes a grafikus hardverregiszterek szinkronban történő manipulálására a videósugárral (pl. Szkennelési soronkénti palettakapcsolókhoz, sprite multiplexeléshez és hardverablakokhoz), vagy a blitter vezérléséhez. 1986 -ban a Texas Instruments kiadta a TMS34010 -et , az első teljesen programozható grafikus processzort. Általános célú kódot tudott futtatni, de grafika-orientált utasításkészlettel rendelkezett. 1990-1992 folyamán ez a chip lett a Texas Instruments Graphics Architecture ("TIGA") Windows gyorsító kártyák alapja .

1987- ben megjelent az IBM 8514 grafikus rendszer, mint az első PC-kompatibilis videokártya, amely rögzített funkciójú 2D primitíveket valósított meg az elektronikus hardverekben . Sharp „s X68000 , megjelent 1987-ben, használt egyedi grafikus lapkakészlet egy 65.536 színpaletta és hardver támogatása sprite, a görgetés és több playfields, végül szolgáló fejlesztési gép Capcom ” s CP rendszer ügyességi fórumon. A Fujitsu később versenyzett az 1989 -ben megjelent FM Towns számítógéppel a teljes 16 777 216 színpaletta támogatásával. 1988 -ban az első dedikált sokszögű 3D grafikus táblákat árkádokban mutatták be a Namco System 21 és a Taito Air System segítségével.

Az IBM által szabadalmaztatott Video Graphics Array (VGA) szabvány került bevezetésre 1987-ben, maximális felbontása 640 × 480 pixel. 1988 novemberében a NEC Home Electronics bejelentette a Video Electronics Standards Association (VESA) létrehozását a Super VGA (SVGA) számítógépes megjelenítési szabvány kifejlesztése és népszerűsítése érdekében, az IBM szabadalmaztatott VGA megjelenítési szabványának utódjaként. A Super VGA kompatibilis grafikus kijelző felbontása akár 800 × 600 képpont , ami 36% -os növekedést jelent.

1990 -es évek

1991 -ben az S3 Graphics bemutatta az S3 86C911 -et , amelyet tervezői a Porsche 911 -ről neveztek el az ígért teljesítménynövekedés jelzéseként. A 86C911 számos utánzót hozott létre: 1995 -re az összes nagy PC grafikus chipgyártó 2D -s gyorsítási támogatást adott a chipekhez. Ekkorra a fix funkciójú Windows gyorsítók felülmúlták a drága általános célú grafikus társprocesszorokat a Windows teljesítményében, és ezek a társprocesszorok elhalványultak a PC-piacról.

Az 1990 -es években a 2D GUI gyorsulás tovább fejlődött. A gyártási képességek javulásával a grafikus chipek integráltsága is javult. További alkalmazás programozási felületek (API-k) érkezett a különböző feladatokat, mint például a Microsoft Wing grafikus könyvtár számára Windows 3.x , és azok későbbi DirectDraw interfész hardveres gyorsítást a 2D-s játékok a Windows 95 és újabb.

A kilencvenes évek elején és közepén a valós idejű 3D - s grafika egyre gyakoribbá vált az arcade, számítógépes és konzolos játékokban, ami miatt egyre nagyobb volt a nyilvánosság igénye a hardveresen gyorsított 3D grafika iránt . A tömegesen vásárolt 3D grafikus hardverek korai példái megtalálhatók az arcade alaplapokon, mint például a Sega Model 1 , Namco System 22 és Sega Model 2 , valamint az ötödik generációs videojáték-konzolokon, mint például a Saturn , PlayStation és Nintendo 64 . Az olyan árkádrendszerek, mint a Sega Model 2 és a Namco Magic Edge Hornet Simulator 1993 -ban, képesek voltak hardveres T&L ( átalakítás, vágás és világítás ) évekre, mielőtt megjelentek a fogyasztói grafikus kártyákon. Egyes rendszerek DSP -ket használtak az átalakítások felgyorsítására. A Fujitsu , amely a Sega Model 2 árkádrendszeren dolgozott , 1995 -ben kezdett el dolgozni a T&L egyetlen LSI megoldásba való integrálásán , otthoni számítógépeken való használatra; A Fujitsu Pinolite, az első 3D-s geometria processzor a személyi számítógépek, megjelent 1997-ben az első hardveres T & L GPU hazai videojáték-konzolok -ben a Nintendo 64 „s Reality Koprocesszor , megjelent 1996-ban 1997-ben, a Mitsubishi kiadta a 3Dpro / 2MP , átalakításra és világításra képes teljes funkcionalitású GPU munkaállomásokhoz és Windows NT asztali számítógépekhez; Az ATi 1997 -ben kiadott FireGL 4000 grafikus kártyájához használta fel .

A "GPU" kifejezést a Sony az 1994-ben megjelent PlayStation videojáték-konzolban a 32 bites Sony GPU -ra hivatkozva alkotta meg (a Toshiba tervezte ) .

A PC-világban az S3 ViRGE , az ATI Rage és a Matrox Mystique figyelemre méltó sikertelen első próbálkozások voltak az olcsó 3D grafikus chipekkel . Ezek a chipek lényegében az előző generációs 2D gyorsítók voltak, 3D funkciókkal. Sokan még pin-kompatibilisek is voltak a korábbi generációs chipekkel a könnyű megvalósítás és a minimális költségek miatt. Kezdetben a nagy teljesítményű 3D -s grafika csak a 3D -s funkciók gyorsítására szánt különálló táblákkal volt lehetséges (és teljesen hiányzik a 2D grafikus felhasználói felület gyorsítása), például a PowerVR és a 3dfx Voodoo . Mivel azonban a gyártási technológia tovább fejlődött, a videót, a 2D GUI gyorsítást és a 3D funkcionalitást egy chipbe integrálták. A Rendition Verite lapkakészletei az elsők között voltak, akik ezt elég jól teljesítették ahhoz, hogy érdemes legyen megjegyezni. 1997-ben a Rendition egy lépéssel tovább lépett, együttműködve a Herkulesszel és a Fujitsuval egy "Thriller Conspiracy" projekten, amely egy Fujitsu FXG-1 Pinolite geometria processzort és egy Vérité V2200 magot ötvözött egy grafikus kártya létrehozásához teljes T&L motorral évekkel az Nvidia GeForce előtt 256 . Ez a kártya, amelynek célja a rendszer CPU -jának terhelésének csökkentése, soha nem került piacra.

Az OpenGL a 90 -es évek elején jelent meg professzionális grafikus API -ként, de eredetileg olyan teljesítményproblémákkal küzdött, amelyek lehetővé tették a Glide API számára, hogy a 90 -es évek végén a PC meghatározó erejévé váljon. Ezeket a problémákat azonban gyorsan leküzdötték, és a Glide API leesett. Az OpenGL szoftveres megvalósításai gyakoriak voltak ebben az időben, bár az OpenGL hatása végül széles körű hardvertámogatáshoz vezetett. Az idő múlásával paritás alakult ki a hardverben és az OpenGL -ben kínált szolgáltatások között. A DirectX a 90 -es évek végén vált népszerűvé a Windows játékfejlesztők körében . Az OpenGL-lel ellentétben a Microsoft ragaszkodott ahhoz, hogy szigorú, egy az egyben támogassa a hardvert. A megközelítés kezdetben kevésbé népszerűvé tette a DirectX -et önálló grafikus API -ként, mivel sok GPU saját sajátosságaival rendelkezik, amelyekből a meglévő OpenGL -alkalmazások már részesülhettek, így a DirectX gyakran egy generációt hagyott hátra. (Lásd: OpenGL és Direct3D összehasonlítása .)

Idővel a Microsoft szorosabban kezdett együttműködni a hardverfejlesztőkkel, és a DirectX kiadásait kezdte megcélozni, hogy megegyezzen a támogató grafikus hardverekkel. A Direct3D 5.0 volt az egyre növekvő API első verziója, amely széles körben elterjedt a játékpiacon, és közvetlenül versenyzett számos hardver-specifikus, gyakran saját grafikus könyvtárral, míg az OpenGL erős követést tartott fenn. A Direct3D 7.0 bevezette a hardveresen gyorsított átalakítás és világítás (T&L) támogatását a Direct3D számára, míg az OpenGL ezt a képességet már a kezdetektől kitette. A 3D gyorsítókártyák túlmutattak azon, hogy egyszerű raszterizátorok legyenek, hogy újabb jelentős hardverfokozattal bővítsék a 3D renderelési folyamatot. Az Nvidia GeForce 256 (más néven NV10) volt az első fogyasztói szintű kártya, amely megjelent a piacon hardveresen gyorsított T&L-vel, míg a professzionális 3D kártyák már rendelkeztek ezzel a képességgel. A hardverátalakítás és a világítás, mind az OpenGL már meglévő szolgáltatásai, a 90-es években eljutottak a fogyasztói szintű hardverekhez, és precedenst teremtettek a későbbi, sokkal rugalmasabb és programozhatóbb pixel shader és vertex shader egységek számára.

2000 -től 2010 -ig

Az Nvidia először gyártott programozható árnyékolásra képes chipet ; a GeForce 3 (kódnév: NV20). Mostantól minden képpont feldolgozható egy rövid "programmal", amely további kép textúrákat is tartalmazhat bemenetként, és minden geometriai csúcsot ugyanígy feldolgozhat egy rövid program, mielőtt a képernyőre vetítené. Az Xbox konzolban használt, a PlayStation 2 -vel versenyzett , amely egyedi vektoros egységet használt a hardveres gyorsított csúcsfeldolgozáshoz (közismert nevén VU0/VU1). A legkorábbi inkarnációja shader végrehajtás motorok használt Xbox nem volt általános célú, és nem tetszőleges pixel kódot. A csúcsokat és a képpontokat különböző egységek dolgozták fel, amelyek saját erőforrásokkal rendelkeztek, sokkal szigorúbb megszorításokkal rendelkező pixelárnyékolókkal (mivel sokkal magasabb frekvenciákon hajtják végre őket, mint csúcsokkal). A pixel árnyékoló motorok valójában inkább egy nagymértékben testreszabható funkcióblokkhoz hasonlítottak, és nem igazán "futtattak" programot. A csúcsok és a pixelek árnyékolása közötti sok ilyen eltérést csak jóval később oldották meg az Unified Shader Model segítségével .

2002 októberére az ATI Radeon 9700 (más néven R300) bemutatásával a világ első Direct3D 9.0 gyorsítója, pixel- és csúcsárnyékolói megvalósíthatták a hurok és a hosszú lebegőpontos matematikát, és gyorsan olyan rugalmasak lettek, mint a CPU -k, mégis megrendelések nagyságrendekkel gyorsabb a képtömb-műveleteknél. A képpont -árnyékolást gyakran használják dudor -leképezéshez , amely textúrát ad hozzá, hogy egy objektum fényes, fénytelen, érdes vagy akár kerek vagy extrudált legyen.

Az Nvidia GeForce 8 sorozat bevezetésével , majd az új, általános adatfolyam -feldolgozó egység GPU -kkal általánosabb számítástechnikai eszközök lettek. Ma, a párhuzamos GPU már megkezdték a számítási eredményeket elérni a CPU ellen, és egy részterület kutatási, szinkronizált GPU Computing vagy GPGPU az általános célú számítást a GPU , megtalálta az utat a területeken olyan változatos, mint a gépi tanulás , olajkutatás , tudományos képfeldolgozás , lineáris algebra , statisztika , 3D rekonstrukció és akár részvényopciók árazásának meghatározása. A GPGPU annak idején az úgynevezett számítási árnyékoló (pl. CUDA, OpenCL, DirectCompute) előfutára volt, és valójában bizonyos mértékben visszaélt a hardverrel azáltal, hogy az algoritmusoknak továbbított adatokat textúra -térképként kezelte, és algoritmusokat hajtott végre háromszög vagy négyes rajzolásával. megfelelő pixel árnyékolóval. Ez nyilvánvalóan többletköltséget von maga után, mivel az olyan egységek, mint a Scan Converter, ott vesznek részt, ahol nincs rájuk szükség (és a háromszög -manipulációk sem okoznak gondot - kivéve a pixel -árnyékoló meghívását).

Az Nvidia 2007 -ben bevezetett CUDA platformja volt a legkorábban elterjedt programozási modell a GPU -számításhoz. Újabban az OpenCL széles körben támogatott. Az OpenCL a Khronos Group által meghatározott nyílt szabvány, amely lehetővé teszi a kód fejlesztését mind a GPU -k, mind a CPU -k számára, hangsúlyt fektetve a hordozhatóságra. Az OpenCL megoldásokat az Intel, az AMD, az Nvidia és az ARM támogatja, és az Evan's Data friss jelentése szerint az OpenCL a GPGPU fejlesztői platform, amelyet a fejlesztők az USA -ban és az ázsiai -csendes -óceáni térségben a legszélesebb körben használnak.

2010 -től napjainkig

2010 -ben az Nvidia partnerséget kezdett az Audival az autóik műszerfalának működtetésére, a Tegra GPU -kat használva, hogy fokozott funkcionalitást biztosítson az autók navigációs és szórakoztató rendszereihez. Az autókban a GPU-technológia fejlődése elősegítette az önvezető technológiát . Az AMD Radeon HD 6000 sorozatú kártyái 2010 -ben jelentek meg, 2011 -ben pedig az AMD kiadta 6000M sorozatú diszkrét GPU -ját, amelyet mobileszközökben használnak. Az Nvidia Kepler grafikus kártyái 2012 -ben jelentek meg, és az Nvidia 600 -as és 700 -as sorozatú kártyáiban használták. Ennek az új GPU mikroarchitektúrának egyik jellemzője a GPU boost, egy olyan technológia, amely a videokártya órajeleit úgy állítja be, hogy növelje vagy csökkentse a teljesítményt. A Kepler mikroarchitektúrát 28 nm -es eljárással gyártották.

A PS4 és az Xbox One 2013 -ban jelent meg, mindkettő az AMD Radeon HD 7850 és 7790 alapú GPU -ját használja . Az Nvidia Kepler GPU -sorozatát a Maxwell vonal követte, amelyet ugyanezen a folyamaton gyártottak. Az Nvidia 28 nm -es chipjeit a TSMC, a Taiwan Semiconductor Manufacturing Company gyártotta, amely akkor 28 nm -es eljárással gyártott. A múltbeli 40 nm -es technológiához képest ez az új gyártási folyamat 20 százalékos teljesítménynövekedést tett lehetővé, miközben kevesebb energiát vett igénybe. A virtuális valóság fejhallgatók nagyon magas rendszerkövetelményeket támasztanak. A VR fejhallgató -gyártók a GTX 970 -et és az R9 290X -et vagy jobbat javasolták megjelenésük idején. A Pascal az Nvidia 2016 -ban megjelent fogyasztói grafikus kártyáinak következő generációja. A GeForce 10 sorozatú kártyák ezen generációs grafikus kártyák alá tartoznak. 16 nm -es gyártási eljárással készülnek, amely javítja a korábbi mikroarchitektúrákat. Az Nvidia kiadott egy nem fogyasztói kártyát az új Volta architektúra alatt, a Titan V. A Titan XP változásai, a Pascal csúcskategóriás kártyája, többek között a CUDA magok számának növekedését, a tenzor magok hozzáadását és a HBM2-t . A tenzormagok kifejezetten a mély tanuláshoz tervezett magok, míg a nagy sávszélességű memória bekapcsolt, halmozott, alacsonyabb órajelű memória, amely rendkívül széles memóriabuszt kínál, amely hasznos a Titan V rendeltetésének megfelelően. Hangsúlyozandó, hogy a Titan V nem játékkártya, az Nvidia eltávolította a "GeForce GTX" utótagot, amelyet a fogyasztói játékkártyákhoz ad.

2018. augusztus 20-án az Nvidia piacra dobta az RTX 20 sorozatú GPU-kat, amelyek sugárkövető magokat adnak a GPU-khoz, javítva a fényeffektusok teljesítményét. Az AMD Polaris 11 és Polaris 10 GPU-ját 14 nanométeres eljárással állítják elő. Kiadásuk jelentősen növeli az AMD videokártyák teljesítményét wattonként. Az AMD a Vega GPU sorozatot is kiadta a csúcskategóriás piac számára, mint az Nvidia csúcskategóriás Pascal kártyáinak versenytársa, amely szintén a HBM2 -t, mint a Titan V -t tartalmazza.

2019 -ben az AMD kiadta a Graphics Core Next (GCN) mikroarchitektúra/utasításkészlet utódját . Az RDNA névre keresztelt első termékcsalád, amely az első generációs RDNA -t tartalmazza, a Radeon RX 5000 videokártya -sorozat volt, amelyet később, 2019. július 7 -én dobtak piacra. Később a vállalat bejelentette, hogy az RDNA mikroarchitektúra utódja frissítés lesz. Az RDNA 2 névre keresztelt új mikroarchitektúrát a tervek szerint 2020 negyedik negyedévében tervezték kiadni.

Az AMD 2020. október 28-án egy online eseményen bemutatta a Radeon RX 6000 sorozatot , a következő generációs RDNA 2 grafikus kártyát, amely támogatja a hardveresen gyorsított sugárkövetést. . Az RX 6800 és 6800 XT 2020.

A PlayStation 5 és az Xbox Series X és Series S 2020 -ban jelent meg, mindkettő az RDNA 2 mikroarchitektúrán alapuló GPU -kat használ , saját fejlesztésekkel és különböző GPU -konfigurációkkal az egyes rendszerek megvalósításában.

GPU -vállalatok

Sok vállalat gyártott GPU -kat számos márkanév alatt. 2009 -ben az Intel , az Nvidia és az AMD / ATI volt a piacvezető, 49,4% -os, 27,8% -os és 20,6% -os piaci részesedéssel. Ezek a számok azonban tartalmazzák az Intel integrált grafikus megoldásait GPU -ként. Ha ezeket nem vesszük figyelembe, az Nvidia és az AMD 2018 -ban közel 100% -ban uralja a piacot. Piaci részesedésük 66% és 33%. Ezenkívül a Matrox GPU -kat gyárt. A modern okostelefonok többnyire a Qualcomm Adreno GPU -ját , az Imagination Technologies PowerVR GPU -ját és az ARM Mali GPU -ját is használják .

Számítási funkciók

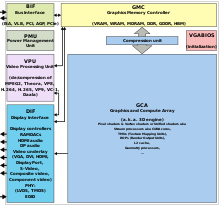

A modern GPU -k tranzisztoruk nagy részét a 3D számítógépes grafikával kapcsolatos számítások elvégzésére használják . A 3D -s hardverek mellett a mai GPU -k alapvető 2D gyorsítási és framebuffer képességeket tartalmaznak (általában VGA -kompatibilitási móddal). Az újabb kártyák, például az AMD/ATI HD5000-HD7000 még a 2D gyorsítást sem tartalmazzák; 3D hardverrel kell emulálni. GPU eredetileg gyorsítására alkalmas memória-intenzív munkája textúraleképezési és rendering sokszög, később hozzátéve egységek felgyorsítása geometriai számításokat, mint a forgatás és a fordítást a csúcsok különböző koordináta-rendszerben . A GPU-k legújabb fejlesztései közé tartozik a programozható árnyékolók támogatása, amelyek manipulálhatják a csúcsokat és a textúrákat a CPU-k által támogatott számos művelet segítségével , túlmintavételezési és interpolációs technikák az álnév csökkentése érdekében , és nagyon nagy pontosságú színtér . Tekintettel arra, hogy a legtöbb ilyen számítások vonja mátrix és vektor műveletek, a mérnökök és tudósok egyre tanulmányozták a használatát GPU nem grafikus számításokat; különösen alkalmasak más kínosan párhuzamos problémákra.

A GPU felépítésének számos tényezője befolyásolja a kártya teljesítményét a valós idejű megjelenítéshez. Gyakori tényezők lehetnek a félvezető eszköz gyártásakor a csatlakozási útvonalak mérete , az órajel frekvenciája, valamint a különböző chipes memória- gyorsítótárak száma és mérete . Ezenkívül a Streaming Multiprocesszorok (SM) száma az NVidia GPU-k, vagy a Compute Units (CU) az AMD GPU-k esetében, amelyek leírják a GPU-chipen belüli, magon belüli szilícium-processzor egységek számát, amelyek elvégzik az alapvető számításokat, általában párhuzamosan más SM/CU -k a GPU -n. Teljesítménye GPU jellemzően mért lebegőpontos művelet másodpercenként, vagy flop , a GPU a 2010-es évek és a 2020-as évek tipikusan nyilvánított mért teljesítményt teraflop (TFLOPS). Ez egy becsült teljesítménymérő, mivel más tényezők is befolyásolhatják a tényleges megjelenítési arányt.

A mély tanulás megjelenésével a GPU -k jelentősége megnőtt. Az Indigo által végzett kutatások során kiderült, hogy a mélytanuló neurális hálózatok képzése közben a GPU 250 -szer gyorsabb lehet, mint a CPU -k. Ezen a területen némi verseny alakult ki az ASIC -ekkel , leginkább a Google által gyártott Tensor Processing Unit (TPU) rendszerrel. Az ASIC -k azonban a meglévő kód módosítását igénylik, és a GPU -k továbbra is nagyon népszerűek.

GPU gyorsított videó dekódolás és kódolás

A legtöbb 1995 óta gyártott GPU támogatja a YUV színteret és a hardveres átfedéseket , amelyek fontosak a digitális videólejátszáshoz, és sok 2000 óta gyártott GPU is támogatja az MPEG primitíveket, például a mozgáskompenzációt és az iDCT -t . A hardveresen gyorsított videódekódolásnak ezt a folyamatát, amikor a videó dekódolási folyamat és a videó utófeldolgozás egyes részeit a GPU hardverébe töltik le, általában "GPU-gyorsított videódekódolásnak", "GPU-as video dekódolásnak", "GPU hardveres gyorsításnak" nevezik. video dekódolás "vagy" GPU hardveres videó dekódolás ".

Az újabb grafikus kártyák még a nagy felbontású videókat is dekódolják a kártyán, lerakva a központi processzort. A GPU gyorsított videó dekódolásának leggyakoribb API-i a DxVA a Microsoft Windows operációs rendszerhez, a VDPAU , a VAAPI , az XvMC és az XvBA a Linux-alapú és UNIX-szerű operációs rendszerekhez. Az XvMC kivételével mindenki képes dekódolni az MPEG-1 , MPEG-2 , MPEG-4 ASP (MPEG-4 Part 2) , MPEG-4 AVC (H.264 / DivX 6), VC-1 , WMV3 / WMV9 kódolású videókat , Xvid / OpenDivX (DivX 4) és DivX 5 kodekek , míg az XvMC csak az MPEG-1 és az MPEG-2 dekódolására képes.

Számos dedikált hardveres videó dekódoló és kódoló megoldás létezik .

Gyorsítható videó dekódolási folyamatok

A videó dekódolási folyamatok, amelyeket a mai modern GPU hardver felgyorsíthat, a következők:

- Mozgáskompenzáció (mocomp)

-

Inverz diszkrét koszinusz transzformáció (iDCT)

- Inverz telecine 3: 2 és 2: 2 lehúzási korrekció

- Inverz módosított diszkrét koszinusz transzformáció (iMDCT)

- Hurkon deblocking szűrő

- Kereten belüli előrejelzés

- Inverz kvantálás (IQ)

- Változó hosszúságú dekódolás (VLD) , közismertebb nevén szelet szintű gyorsítás

- Térbeli-időbeli deinterlacing és automatikus interlace / progresszív forrásérzékelés

- Bitfolyam feldolgozás ( Context-adaptív változó hosszúságú kódolás / Context-adaptív bináris aritmetikai kódolás ) és tökéletes pixelpozicionálás.

A fenti műveleteknek vannak videó szerkesztési, kódolási és átkódolási alkalmazásai is

GPU űrlapok

Terminológia

A személyi számítógépekben a GPU -k két fő formája létezik. Mindegyiknek sok szinonimája van:

- Dedikált grafikus kártya - más néven diszkrét .

- Integrált grafika - más néven: megosztott grafikus megoldások , integrált grafikus processzorok (IGP) vagy egységes memória -architektúra (UMA).

Használatra specifikus GPU

A legtöbb GPU-t meghatározott felhasználásra, valós idejű 3D grafikára vagy más tömegszámításra tervezték:

- Szerencsejáték

- Cloud Gaming

- Nvidia GRID

- Radeon Sky

- Munkaállomás

- Felhő munkaállomás

- Mesterséges intelligencia képzés és felhő

- Automatizált/vezető nélküli autó

- Nvidia Drive PX

Dedikált grafikus kártyák

A legerősebb osztályú GPU -k jellemzően olyan bővítőnyíláson keresztül kapcsolódnak az alaplaphoz , mint a PCI Express (PCIe) vagy az Accelerated Graphics Port (AGP), és általában viszonylag könnyen cserélhetők vagy frissíthetők, feltéve, hogy az alaplap képes támogatni a frissítés. Néhány grafikus kártya még mindig használja a PCI ( Peripheral Component Interconnect ) bővítőhelyeket, de a sávszélességük annyira korlátozott, hogy általában csak akkor használják, ha nem áll rendelkezésre PCIe vagy AGP bővítőhely.

A dedikált GPU nem feltétlenül cserélhető, és nem feltétlenül szabványos interfész az alaplappal. A "dedikált" kifejezés arra a tényre utal, hogy a dedikált grafikus kártyáknak a kártya használatára szánt RAM -ja van, nem pedig arra, hogy a legtöbb dedikált GPU eltávolítható. Ezenkívül ezt a RAM -ot általában kifejezetten a grafikus kártya várható soros terhelésére választják ki (lásd GDDR ). Néha a dedikált, diszkrét GPU -val ellátott rendszereket DIS -rendszernek nevezték, szemben az UMA -rendszerekkel (lásd a következő részt). A hordozható számítógépekre szánt dedikált GPU-k leggyakrabban nem szabványos és gyakran saját tulajdonú nyíláson keresztül kapcsolódnak a mérethez és a súlyhoz. Az ilyen portok továbbra is PCIe -nek vagy AGP -nek tekinthetők logikai gazdainterfészük szempontjából, még akkor is, ha fizikailag nem cserélhetők fel társaikkal.

Az olyan technológiák, mint az SLI és az NVLink az Nvidia és a CrossFire by AMD lehetővé teszik több GPU számára, hogy egyszerre rajzoljon képeket egyetlen képernyőre, növelve a grafika számára rendelkezésre álló feldolgozási teljesítményt. Ezek a technológiák azonban egyre ritkábbak, mivel a legtöbb játék nem használ ki teljes mértékben több GPU -t, mivel a legtöbb felhasználó nem engedheti meg magának. Továbbra is több GPU -t használnak szuperszámítógépeken (például a Summit -ban ), munkaállomásokon a videó gyorsítására (több videó egyidejű feldolgozása) és 3D -s renderelésre, VFX -re és szimulációkra, valamint az AI -ban, hogy felgyorsítsák a képzést, ahogy az Nvidia DGX munkaállomások és szerverek, Tesla GPU -k és az Intel közelgő Ponte Vecchio GPU -i.

Beépített grafikus feldolgozó egység

Az integrált grafikus feldolgozó egység (IGPU), az integrált grafika , a megosztott grafikus megoldások , az integrált grafikus processzorok (IGP) vagy az egységes memória -architektúra (UMA) a számítógép rendszermemóriájának egy részét használja fel, nem pedig dedikált grafikus memóriát. Az IGP -k integrálhatók az alaplapra a (northbridge) lapkakészlet részeként, vagy ugyanazon a szerszámon (integrált áramkör) a CPU -val (például AMD APU vagy Intel HD Graphics ). Bizonyos alaplapokon az AMD IGP -i dedikált oldalsó port memóriát használhatnak. Ez a nagy teljesítményű memória külön rögzített blokkja, amelyet a GPU használ. 2007 elején az integrált grafikával rendelkező számítógépek teszik ki a PC -szállítások mintegy 90% -át. Ezek megvalósítása olcsóbb, mint a dedikált grafikus feldolgozás, de általában kevésbé képesek. Történelmileg az integrált feldolgozást alkalmatlannak tartották 3D -s játékok lejátszására vagy grafikusan intenzív programok futtatására, de kevésbé intenzív programokat is futtathat, mint például az Adobe Flash. Ilyen IGP -k lehetnek például a SiS és a VIA 2004 -es ajánlatai. Azonban a modern integrált grafikus processzorok, mint például az AMD gyorsított feldolgozó egység és az Intel HD Graphics , több mint képesek 2D grafika vagy alacsony stresszű 3D grafika kezelésére.

Mivel a GPU-számítások rendkívül memóriaigényesek, az integrált feldolgozás versenyezhet a CPU-val a viszonylag lassú rendszer RAM miatt, mivel minimális vagy nincs dedikált videomemória. Az IGP -k akár 29,856 GB/s memória sávszélességgel rendelkezhetnek a rendszer RAM -ból, míg egy grafikus kártya akár 264 GB/s sávszélességet is kaphat a RAM és a GPU magja között. Ez a memóriabusz- sávszélesség korlátozhatja a GPU teljesítményét, bár a többcsatornás memória enyhítheti ezt a hiányosságot. A régebbi integrált grafikus lapkakészletekből hiányzott a hardverátalakítás és a világítás , de az újabbak tartalmazzák.

Hibrid grafikus feldolgozás

Ez az újabb GPU-osztály integrált grafikával versenyez az alacsony kategóriájú asztali és notebook piacokon. Ennek leggyakoribb megvalósításai az ATI HyperMemory és az Nvidia TurboCache .

A hibrid grafikus kártyák valamivel drágábbak, mint az integrált grafikus kártyák, de sokkal olcsóbbak, mint a dedikált grafikus kártyák. Ezek megosztják a memóriát a rendszerrel, és egy kis dedikált gyorsítótárral rendelkeznek, hogy pótolják a rendszer RAM -jának magas késését . A PCI Express technológiái lehetővé teszik ezt. Bár ezeket a megoldásokat néha úgy hirdetik, hogy akár 768 MB RAM -ot tartalmaznak, ez arra utal, hogy mennyit lehet megosztani a rendszermemóriával.

Adatfolyam -feldolgozás és általános célú GPU -k (GPGPU)

Egyre gyakoribb, hogy egy általános célú grafikus feldolgozó egységet (GPGPU) használnak adatfolyam -processzor (vagy vektor -processzor) módosított formájaként , számítási kerneleket futtatva . Ez a koncepció a modern grafikus gyorsító shader csővezetékének hatalmas számítási teljesítményét általános célú számítási teljesítménygé változtatja, szemben azzal, hogy kizárólag grafikus műveletek elvégzésére van bekötve. Bizonyos alkalmazásokban, amelyek hatalmas vektorműveleteket igényelnek, ez több nagyságrenddel nagyobb teljesítményt eredményezhet, mint egy hagyományos CPU. A két legnagyobb diszkrét (lásd a fenti " Dedikált grafikus kártyákat ") GPU -tervezők, az AMD és az Nvidia , számos alkalmazással kezdik ezt a megközelítést alkalmazni. Mind az Nvidia, mind az AMD a Stanford Egyetemmel közösen GPU-alapú klienst hoztak létre a Folding@home elosztott számítási projekthez, a fehérje hajtogatási számításokhoz. Bizonyos körülmények között a GPU negyvenszer gyorsabban számol, mint az ilyen alkalmazások által hagyományosan használt CPU -k.

A GPGPU sokféle kínosan párhuzamos feladatra használható, beleértve a sugárkövetést . Általában alkalmasak nagy teljesítményű típusú számításokra, amelyek adatpárhuzamot mutatnak a GPU széles vektor szélességű SIMD architektúrájának kihasználása érdekében .

Továbbá a GPU-alapú nagy teljesítményű számítógépek jelentős szerepet játszanak a nagyszabású modellezésben. A világ 10 legerősebb szuperszámítógépe közül három kihasználja a GPU -gyorsítást.

A GPU -k támogatják a C programozási nyelv API -bővítményeit, például az OpenCL -t és az OpenMP -t . Ezenkívül minden GPU -gyártó bemutatta saját API -ját, amely csak a kártyájukkal működik, az AMD APP SDK -val és az AMD, illetve az Nvidia CUDA -jával . Ezek a technológiák lehetővé teszik a normál C programból származó, számítási kernelnek nevezett meghatározott funkciók futtatását a GPU adatfolyam -processzorain. Ez lehetővé teszi, hogy a C programok kihasználják a GPU azon képességét, hogy párhuzamosan nagy puffereken tudnak működni, miközben szükség esetén továbbra is a CPU -t használják. A CUDA az első olyan API is, amely lehetővé teszi a CPU-alapú alkalmazások számára, hogy közvetlenül hozzáférjenek a GPU erőforrásaihoz az általánosabb célú számítástechnika számára anélkül, hogy korlátoznák a grafikus API használatát.

2005 óta érdeklődés mutatkozik a GPU -k által kínált teljesítmény általános evolúciós számításra , és különösen a genetikai programozás alkalmasságának felgyorsítására történő felhasználására . A legtöbb megközelítés lineáris vagy fa programokat állít össze a gazda PC -n, és átküldi a futtatható fájlt a GPU -ra. Általában a teljesítményelőny csak akkor érhető el, ha az egyetlen aktív programot egyszerre futtatja számos példaproblémán, párhuzamosan, a GPU SIMD architektúráját használva . Jelentős gyorsulás érhető el azonban azzal is, hogy nem állítjuk össze a programokat, hanem áthelyezzük azokat a GPU -ba, hogy ott értelmezzük. A gyorsulást ezután úgy érhetjük el, hogy vagy több programot egyszerre értelmezünk, egyszerre több példaproblémát futtatunk, vagy mindkettőt kombináljuk. Egy modern GPU egyszerre képes egyszerre több százezer nagyon kicsi program értelmezésére.

Néhány modern munkaállomás GPU, például a Volta és Turing architektúrát használó Nvidia Quadro munkaállomás-kártyák dedikált feldolgozó magokat tartalmaznak a tenzor alapú mélytanulási alkalmazásokhoz. Az Nvidia jelenlegi GPU -sorozatában ezeket a magokat Tensor Core -nak hívják. Ezek a GPU -k általában jelentős FLOPS teljesítménynövekedéssel rendelkeznek, 4x4 mátrix szorzást és osztást alkalmazva, ami egyes alkalmazásokban akár 128 TFLOPS hardverteljesítményt eredményez. Ezek a tenzormagok a Turing architektúrát futtató fogyasztói kártyákon és esetleg az AMD Navi fogyasztói kártyáin is megjelenhetnek.

Külső GPU (eGPU)

A külső GPU egy grafikus processzor, amely a számítógép házán kívül helyezkedik el, hasonlóan egy nagy külső merevlemezhez. Néha külső grafikus processzorokat használnak laptop számítógépekkel. A laptopok jelentős mennyiségű RAM-mal és kellően erős központi processzorral (CPU) rendelkezhetnek, de gyakran hiányzik belőlük egy erős grafikus processzor, és kevésbé hatékony, de energiatakarékosabb fedélzeti grafikus chipjük van. A fedélzeti grafikus chipek gyakran nem elég erősek videojátékok lejátszásához, vagy más grafikailag intenzív feladatokhoz, például videószerkesztéshez vagy 3D-s animációhoz/rendereléshez.

Ezért kívánatos, hogy GPU -t lehessen csatlakoztatni egy notebook külső buszához. A PCI Express az egyetlen busz, amelyet erre a célra használnak. A port lehet például ExpressCard vagy mPCIe port (PCIe × 1, legfeljebb 5 vagy 2,5 Gbit/s) vagy Thunderbolt 1, 2 vagy 3 port (PCIe × 4, legfeljebb 10, 20 vagy 40 Gbit/s). Ezek a portok csak bizonyos notebook rendszereken érhetők el. Az eGPU házak saját tápegységet (PSU) tartalmaznak, mivel az erős GPU -k könnyen több száz wattot fogyaszthatnak.

A külső GPU -k hivatalos gyártói támogatása az utóbbi időben megkapta a hatását. Az egyik figyelemreméltó mérföldkő az Apple döntése volt, hogy hivatalosan támogatja a külső GPU -kat a MacOS High Sierra 10.13.4 segítségével. Számos nagy hardvergyártó (HP, Alienware, Razer) is kiadja a Thunderbolt 3 eGPU házakat. Ez a támogatás továbbra is ösztönzi a rajongók eGPU -megvalósítását.

Értékesítés

2013 -ban 438,3 millió GPU -t szállítottak világszerte, és 2014 -re az előrejelzés 414,2 millió volt.

Lásd még

- Textúra -leképező egység (TMU)

- Render kimeneti egység (ROP)

- Nyers erő támadása

- Számítógép hardver

- Számítógép monitor

- GPU gyorsítótár

- GPU virtualizáció

- Manycore processzor

- Fizikai feldolgozó egység (PPU)

- Tenzorfeldolgozó egység (TPU)

- Sugárkövető hardver

- Szoftver renderelés

- Látásfeldolgozó egység (VPU)

- Vektor processzor

- Videokártya

- Videó kijelző vezérlő

- Videójáték konzol

- AI gyorsító

- GPU Vector Processor belső jellemzői

Hardver

- AMD grafikus feldolgozó egységek összehasonlítása

- Az Nvidia grafikus feldolgozó egységek összehasonlítása

- Intel grafikus feldolgozó egységek összehasonlítása

- Intel GMA

- Larrabee

- Nvidia PureVideo - az Nvidia bitfolyamos technológiája, amelyet a grafikus chipjeikben használtak fel a DXVA -val ellátott hardveres GPU -n történő videó dekódolás felgyorsítására.

- SoC

- UVD (Unified Video Decoder)-videó dekódoló bitfolyam technológia az ATI-tól a hardver (GPU) dekódolás támogatásához a DXVA segítségével

API -k

- OpenGL API

- DirectX Video Acceleration (DXVA) API for Microsoft Windows operációs rendszer.

- Mantle (API)

- Vulkan (API)

- Video Acceleration API (VA API)

- VDPAU (Video Decode and Presentation API for Unix)

- X-Video Bitstream Acceleration (XvBA) , a DXVA X11 megfelelője MPEG-2, H.264 és VC-1 esetén

- X-Video Motion Compensation- az X11 megfelelője csak az MPEG-2 videokodekhez

Alkalmazások

- GPU -fürt

- Mathematica- tartalmazza a CUDA és az OpenCL GPU végrehajtásának beépített támogatását

- Molekuláris modellezés GPU -n

- Deeplearning4j- nyílt forráskódú, elosztott mély tanulás Java számára